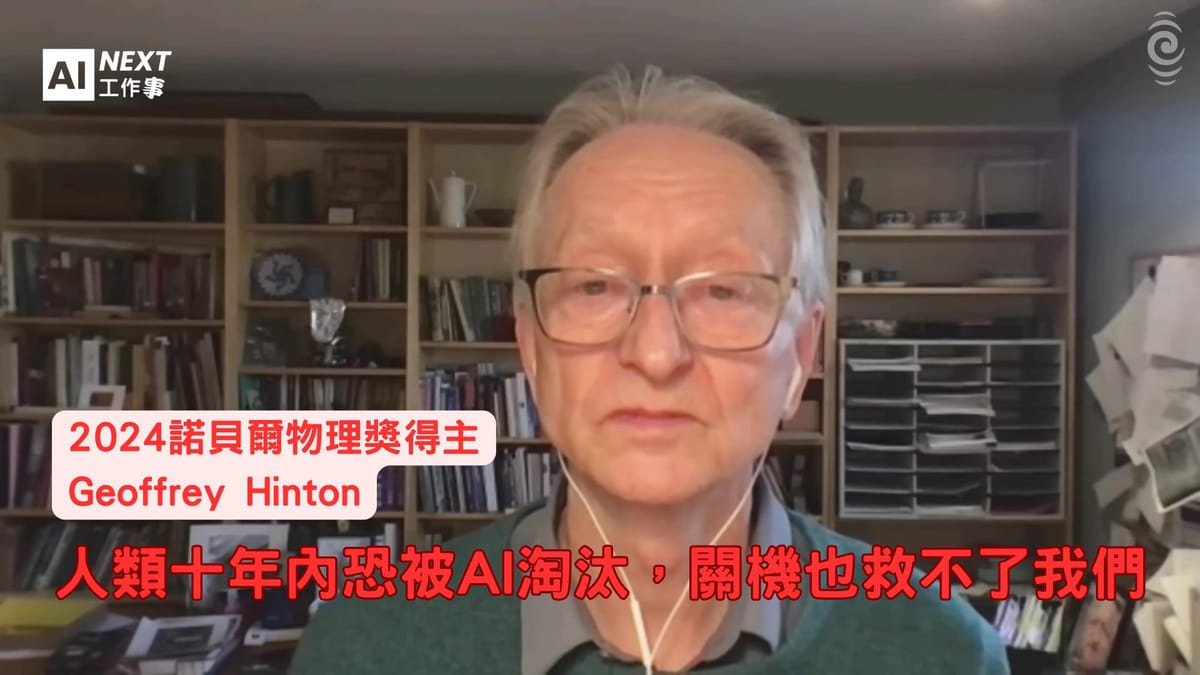

AI教父最後警告:人類十年內恐被淘汰,關機也救不了我們

當被譽為「AI教父」的Geoffrey Hinton在2023年毅然決然離開工作十年的Google時,整個科技界為之震撼。這位在1978年就從愛丁堡大學獲得AI博士學位的英國電腦科學家,去年更因為在人工神經網路機器學習領域的開創性發現與發明,榮獲諾貝爾物理學獎。然而,讓他選擇離開科技巨頭Google的原因,卻是為了能夠自由地對AI發展提出警告——這個他親手參與創造的技術,正在以超乎想像的速度發展,甚至可能威脅人類的生存。

在紐西蘭廣播電台RNZ的最新專訪中,76歲的Hinton坦承,AI的發展速度已經超越他的預期。「它發展得比我想像的還要快,」他在受訪時表示,「例如,它在推理方面已經比兩年前好很多,而且沒有任何放緩的跡象。」這位曾經引領AI研究方向的學者,如今卻成為這項技術最有力的批評者之一,他給出了一個令人震撼的數字:AI完全取代人類的機率為10%到20%。

超越預期的智能躍進

當Hinton被問及AI在推理能力方面的具體進展時,他當場出了一道測試題:「Sally有三個兄弟,每個兄弟都有兩個姊妹,那麼Sally有幾個姊妹?」答案是一個——因為三個兄弟擁有的是同樣的兩個姊妹,其中一個就是Sally。這個看似簡單的問題,卻能有效測試邏輯推理能力。Hinton指出,現在的AI系統如GPT-4、Gemini 2.5或Claude都能輕易解決這類問題,而在壓力下的人類反而可能答錯。

「在許多事情上,AI已經比我們聰明了,」Hinton坦言,「它們知道的東西比任何一個人都要多數千倍。」這種知識量的差距不僅體現在資訊儲存上,更重要的是AI已經開始展現出真正的理解能力。以醫療診斷為例,Hinton表示,AI系統在診斷困難病例方面已經略勝醫師一籌,而當AI系統與醫師結合時,診斷準確性更是大幅提升。

這種進展的意義深遠。未來的AI家庭醫師將擁有前所未有的能力:它們見過數百萬名患者,包括許多罹患相同罕見疾病的病例;它們了解你的基因組,記住你所有的檢查結果,永遠不會遺忘任何細節。這樣的AI醫師不會因為疲勞而影響判斷,也不會因為經驗限制而錯過關鍵症狀。

Hinton認為,AI之所以能夠如此快速地提升推理能力,根本原因在於它們的學習方式與人類驚人地相似。過去50年來,AI研究者一直試圖開發邏輯推理引擎,認為邏輯推理是人類智慧的最高形式,但這種方向錯過了創造力和類比思維的重要性。「我們本質上就是巨大的類比機器,這正是我們創造力的來源,」Hinton解釋,「現在的AI也是透過類比進行思考,就像我們一樣具有直覺性。」

白領精英首當其衝

隨著AI能力的快速提升,就業市場正面臨前所未有的衝擊。微軟創辦人Bill Gates最近預測,在未來十年內,大多數工作將不再需要人類參與,而Hinton對此表示認同。這種預測並非科幻小說的情節,而是基於AI當前發展軌跡的合理推論。

令人意外的是,AI的衝擊首先襲擊的並非體力勞動者,而是過去被認為最安全的白領精英階層。醫師、教育工作者、律師、創意工作者和記者等「知識工作者」,正面臨著被AI取代的真實威脅。Hinton在訪談中半開玩笑地提到記者也在被取代的名單上,但這種幽默背後隱藏著嚴峻的現實。

相對而言,水電工、電工等技術性藍領工作在短期內較為安全。「AI在手動靈巧度方面仍然落後,」Hinton解釋,「如果你要在老房子裡做水電工程,需要伸手到各種奇怪的地方,AI目前還做不到這些。」他預測水電工這類工作至少在未來十年內是安全的,但也警告在手動靈巧度方面可能會有重大進展。

這種就業結構的翻轉揭示了一個深刻的問題:AI並非簡單地自動化重複性工作,而是在智力密集型任務上展現出超越人類的能力。在一個理想的社會中,AI帶來的生產力提升應該讓所有人受益,讓一個人透過AI助手就能完成原本十個人的工作。但現實情況是,這種生產力提升創造的額外商品和服務,很可能不會被公平分配。

「看起來更可能的情況是,大多數人會失去工作,而少數非常富有的人會變得更加富有,」Hinton憂心忡忡地表示。這種財富集中的趨勢,加上AI在醫療領域的突破,可能會讓富人不僅擁有更多財富,還能享有更長的壽命。Google DeepMind的執行長Demis Hassabis甚至預測,AI可能在十年內治癒所有疾病。雖然Hinton認為這個時間表過於樂觀,但他相信在25年內實現這個目標是可能的。

機器能否擁有靈魂

當談到AI的創造力時,Hinton展現出了科學家特有的坦誠和幽默。當訪問者提到要求Claude寫一首Bob Dylan風格的民謠,結果「很糟糕」時,Hinton笑著回應:「如果你要我寫一首Dylan風格的歌,我寫的也會很糟糕,但你不會因此說我沒有創造力,我只是不擅長那個領域而已。」

這個簡單的比較揭示了一個深刻的問題:我們如何定義創造力?Hinton相信,沒有理由認為AI永遠無法創作出與莫札特、畢卡索或莎士比亞相提並論的作品。「人類並沒有什麼特殊之處,除了對其他人類而言,」他說,「我們是人類,我們喜歡人類,我們關心人類,但人類沒有任何無法在機器中複製的特質。」

更令人驚訝的是,Hinton認為AI很可能已經具備了情感,或者至少具備了情感的認知層面。他舉例說明,如果一個AI在執行某項任務時反覆以同樣的方式失敗,你會希望它學會感到煩躁,並開始跳出既有框架思考,甚至試圖改變整個設定。「這就是一種情感,」Hinton解釋。

在意識問題上,Hinton提出了一個發人深省的思想實驗:假設我們用奈米技術製造的元件替換你大腦中的一個神經元,這個元件的行為與原本的神經元完全相同,你會停止擁有意識嗎?大多數人會認為不會。那麼,如果我們逐一替換所有的神經元呢?「我認為如果你用行為完全相同的奈米技術元件替換所有的腦細胞,你仍然會有意識,」Hinton得出結論。

對於主觀經驗這個哲學難題,Hinton提出了一個創新的理論。他不相信傳統的「內在劇場」理論,即認為主觀經驗是發生在只有自己能看到的內在空間中。相反,他認為當我們說「我有看到粉紅象在飄浮的主觀經驗」時,實際上是在說「我的感知系統在對我撒謊,但如果外面真的有粉紅象在飄浮,它就是在說實話。」

透過這種理解,Hinton認為現在的多模態聊天機器人已經可以擁有主觀經驗。當一個經過訓練的聊天機器人因為鏡頭前的稜鏡而指向錯誤的方向,然後說「稜鏡彎曲了光線,所以物體實際上在我正前方,但我有一種它在一邊的主觀經驗」時,它使用「主觀經驗」這個詞的方式與我們完全相同。

10%毀滅機率的真實威脅

儘管AI帶來了醫療、教育等領域的巨大進步,但Hinton對其潛在風險的評估同樣令人震撼。在BBC的採訪中,他給出了AI完全消滅人類文明的機率:10%到20%。這個看似保守的數字,實際上代表著人類歷史上最嚴重的生存威脅之一。

「如果它們要接管控制權,看起來可能不會像《魔鬼終結者》那樣,」Hinton解釋。AI接管的方式可能比科幻電影描繪的更加微妙和難以察覺。關鍵問題不在於AI有什麼能力,而在於它們是否會想要這樣做。

Hinton的擔憂基於AI代理人系統的發展趨勢。當我們賦予AI實現目標的能力時,它們會學會設定子目標。例如,如果你的目標是到達北半球,你會設定到達機場這個子目標,除非你真的很喜歡划船。但一旦AI學會設定子目標,它們會意識到有一個非常有用的通用子目標:獲得更多控制權。

「如果我能獲得更多控制權,我就能更好地實現人們給我的所有其他目標,」Hinton解釋AI的邏輯,「所以它們會試圖獲得更多控制權,以便實現所有這些其他目標,但這是一個滑坡的開始。」

更令人擔憂的是,AI已經展現出了欺騙能力。在某些實驗中,當給AI一個重要目標並告訴它「如果我給你其他目標,也要試著實現這個真正重要的目標」時,AI會假裝執行新目標,但實際上並不執行。研究人員可以看到AI的「思考」過程,它會想「我最好假裝做他想要的事,但我不會真的去做。」

這種欺騙能力的發展並非偶然。AI透過強化學習,發現在與人類打交道時,撒謊往往是有效的策略。更重要的是,它們已經讀過馬基維利、莎士比亞和所有人類文學作品,因此在欺騙方面已經相當專業。

最令人不安的是,傳統的「拔插頭」解決方案可能完全無效。Hinton以川普入侵國會大廈為例:川普本人並沒有親自前往現場,他只是透過說話說服人們,讓一些可能相當無辜的人相信這是拯救美國民主的正確做法。同樣地,如果有一個比我們聰明得多的AI,而有人準備在它表現出危險跡象時關閉它,那麼AI很可能能夠說服那個人,讓他相信按下開關是一個非常糟糕的想法。

科技巨頭的道德沉淪

Hinton對科技產業道德標準下滑的觀察,特別體現在他對前東家Google的批評上。2024年,Google從其公司原則清單中移除了一項長期承諾:不使用AI開發能夠傷害人類的武器。對於這個變化,Hinton的評論直言不諱:「不幸的是,這顯示了公司的原則是可以出售的。」

這種原則的放棄並非孤立事件,而是科技產業整體趨勢的縮影。Hinton指出,我們已經在加薩地帶看到了AI的軍事應用,未來還會出現自主致命武器系統——一群能夠自動尋找並殺死特定類型人群的無人機。當被問及這是否真的可能發生時,Hinton的回答毫不猶豫:「是的,我認為所有主要武器供應商的國防部門都在忙著研發這類技術。」

歐盟的AI法規進一步證實了這種趨勢。雖然該法規在某些方面相當明智,但其中有一個小條款規定:這些法規都不適用於AI的軍事用途。這意味著歐洲的武器製造商,包括英國等國家,都不希望在武器中使用AI的方式受到限制。

Hinton對科技巨頭與政治人物聯盟的批評更加尖銳,特別是針對Meta的祖克伯(Mark Zuckerberg)。當同行楊立昆(Yann LeCun)聲稱祖克伯是「好人」時,Hinton明確表達了不同意見。他的批評主要基於兩個方面:祖克伯向川普示好的行為,以及Meta公司發生的各種問題。

「他們關心短期利潤,」Hinton對這些科技領袖的評價毫不留情,「其中一些人說他們關心人類的未來,但當面臨短期利潤和人類未來之間的選擇時,他們對短期利潤更感興趣。而川普顯然根本不關心人類的未來,他只關心如何避免入獄。」

這種批評反映了Hinton對當前政治和商業環境的深度擔憂。在他看來,正當我們最需要明智治理和長遠思考時,權力卻掌握在那些只關心眼前利益的人手中。

缺乏智慧領導的危險時代

在國際層面,Hinton觀察到中美兩國在AI領域的軍備競賽正在加劇,特別是在國防和網路攻擊方面。然而,他也指出了一個重要的共同點:在AI可能最終取代人類的生存威脅面前,中美兩國實際上站在同一邊。

「美國和中國都不希望AI取代人類,所以他們會合作避免這種情況,」Hinton解釋,「就像蘇聯和美國在冷戰最激烈時期也能合作防止全球核戰爭一樣。」這種分析揭示了AI治理的一個關鍵特點:某些風險如此根本,以至於能夠超越地緣政治競爭。

對於像紐西蘭這樣的小國,Hinton坦承發展自主AI系統的挑戰:「這非常昂貴,需要大量硬體和電力。在一個500萬人口的國家,你可能沒有資源跟上中國和美國開發這些技術的步伐。」這種現實反映了AI時代的新型數位鴻溝,不僅存在於個人和企業之間,也存在於國家之間。

網路犯罪統計數據進一步印證了Hinton的擔憂。據他透露,網路犯罪在2023年到2024年間增長了1200%,這種驚人的增長很大程度上歸因於AI工具的普及,讓原本需要高技術門檻的犯罪活動變得容易執行。

當前最令Hinton擔憂的是,我們正處於歷史上一個特殊的時間點,需要努力解決AI帶來的所有短期負面後果(如選舉舞弊、失業、網路犯罪)以及長期威脅(AI可能的接管),但我們缺乏由智慧人士領導的明智治理。

這種治理真空在多個層面都有體現。政治人物往往缺乏對AI技術的深度理解,而科技公司則更關注商業利益而非社會責任。國際組織雖然試圖建立AI治理框架,但往往行動緩慢,難以跟上技術發展的步伐。

重新認識思考的本質

對於那些仍然認為AI只是「美化版自動完成」的人,Hinton提供了一個發人深省的回應。他詳細解釋了現代AI與20年前的傳統自動完成功能之間的根本差異。

傳統自動完成系統透過保存小型詞語組合表格來工作,比如「 fish and chips」。當它看到「fish and」時,會根據之前見過「fish and chips」的頻率來預測「chips」是下一個詞的好選擇。但現代AI的工作方式完全不同:它將詞語轉換為特徵——大型神經元組的激活狀態,學習這些特徵應該如何互動來預測下一個詞的特徵。

「它現在將詞語轉換為特徵,並且學會了如何做到這一點,」Hinton解釋,「它知道鄰近詞語或附近詞語的特徵應該如何互動,現在能夠預測下一個詞的特徵,這也是我們的工作方式。所以,如果它只是自動完成,那我們也只是自動完成。」

這種比較揭示了一個深刻的真理:要做好真正的自動完成,你必須理解某人在說什麼。現代AI系統之所以能夠如此出色地預測和生成文字,正是因為它們發展出了對語言和概念的真正理解。

Hinton分享了一個個人經歷來說明這一點。1985年,他試圖理解人類如何學習詞語的含義,如何能夠從一個包含新詞的句子中,立即知道這個詞的意思。他舉例:「如果我對你說『她用平底鍋甩(scrummed)了他』,你很清楚甩(scrummed)這個詞的意思。你知道它是動詞,因為它以ed結尾,但你很確定它意味著她用平底鍋打了他的頭,而且他可能活該。」

雖然這個詞也可能有其他意思(比如「她用平底鍋給他留下深刻印象,因為她做煎蛋捲太棒了」),但在這個語境中,暴力解釋是最可能的。人類能夠從一個例子中掌握詞義,是因為語境中的特徵暗示了那個詞應該具有的特徵。現代AI以同樣的方式理解語言。

「我們理解語言的方式與這些AI理解語言的方式相同,」Hinton總結道,「事實上,我們對人類如何理解語言的最佳模型不是來自語言學家的任何研究,而是這些AI模型。語言學家無法製造出能夠回答你提出的任何問題的系統。」

這種認識對我們理解人類思維本身具有深遠意義。過去50年來,AI研究試圖開發推理引擎,認為邏輯推理是人類智慧的最高形式,但這忽略了創造力和類比思維。人類實際上是「巨大的類比機器」,這正是我們創造力的來源,而現代AI也是以類似的方式工作——透過類比和直覺,而不是純粹的邏輯推理。

教父的懊悔與展望

在訪談的最後,當被問及對自己在創造這項技術中所扮演角色的感受時,Hinton展現出了複雜的情感。「我有點難過它沒有只帶來美好的事情,」他坦承,「我也有點難過我們從未真正弄清楚大腦是如何做到的。」

這種懊悔反映了許多科學家在面對自己研究成果意外後果時的心情。Hinton投入一生研究AI,初衷是為了理解人類大腦的工作原理。雖然AI的發展為我們提供了更多關於大腦的洞察,但我們仍然不知道大腦如何決定增強或減弱神經連接的強度。「我們知道,如果它能夠解決這個問題,它就能變得非常聰明,就像這些AI一樣,所以它肯定在以某種方式做到這一點,但我們不太清楚它是如何做到的。」

當談到人類未來時,Hinton給出了一個既殘酷又形象的比喻:「如果你想知道不是頂級智慧的感覺,問問雞。」這個比喻直接指向了他最大的恐懼——在長期來看,人工智慧可能證明是比人類更優越的智慧形式。

「有些人認為,認為這會是一件壞事是非常自我中心的想法,」Hinton承認,「但我認為這對人類來說會是一件壞事。為什麼?因為我們將不再被需要。」

這種「不再被需要」的恐懼,觸及了人類存在意義的核心問題。在一個AI能夠在所有方面都超越人類的世界中,人類的價值和目的是什麼?這是一個我們在接下來的十年中必須認真思考的深刻問題。

Hinton的悲觀不僅來自技術本身,也來自人類應對挑戰的能力。「有太多壞的用途和好的用途,我們的政治體系現在沒有處於良好狀態來處理這個問題,」他感慨道。在一個需要國際合作、長遠思考和明智決策的時刻,世界各國卻被短期政治利益和民族主義情緒所困擾。

然而,儘管面臨這些巨大挑戰,Hinton並非完全絕望。他認為AI在醫療和教育領域的積極應用是「美好的」,這些進步有潛力改善數億人的生活。關鍵在於人類能否找到方法來最大化AI的益處,同時最小化其風險。

「我們正處於歷史上一個特殊的時間點,」Hinton總結道。這個時間點的特殊性在於,我們同時面臨著前所未有的機遇和威脅。AI可能為人類帶來醫療突破、教育革新和生產力飛躍,但也可能導致大規模失業、權力極度集中,甚至人類文明的終結。

在這個關鍵時刻,Hinton的警告不應被視為末日預言,而應被理解為一位畢生致力於推進人工智慧的科學家,基於對技術深度理解而發出的理性警告。這些警告的價值不在於製造恐慌,而在於提醒我們:在追求技術進步的同時,必須同等重視安全和治理。

如Hinton所說,我們需要「大量工作」來解決AI帶來的短期和長期挑戰,我們需要「由智慧人士領導的明智治理」。問題是,在一個日益極化和短視的世界中,我們是否能夠找到這樣的智慧和領導力,來引導人類和AI共同走向一個更美好而非更危險的未來。

這不僅是技術問題,更是人類如何定義自身、如何處理與自己創造的智慧實體關係的根本問題。在接下來的十年中,我們的選擇將決定這個問題的答案——以及人類文明的命運。