大神首度齊聚!「快跟黃仁勳出來看Transformer八仙」

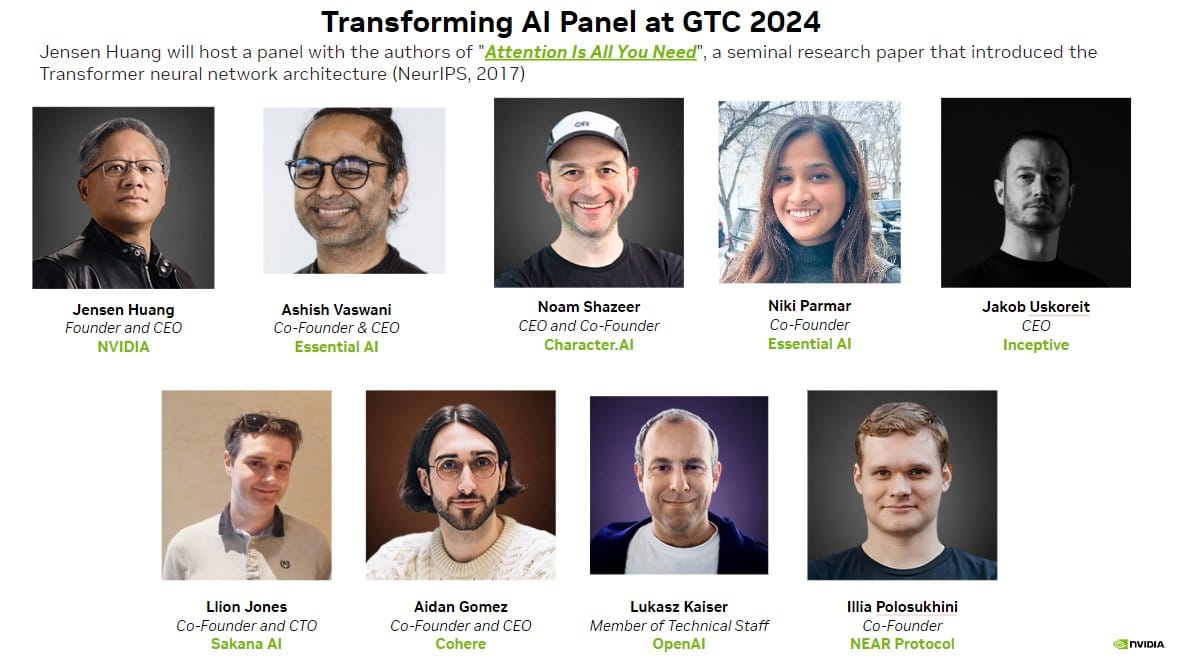

NVIDIA創辦人暨執行長黃仁勳在GTC 2024主持了一場特別座談,邀請到傳奇研究論文「Attention Is All You Need」的七位作者同台。這場彷彿「七仙下凡」的盛會,讓與會者直呼「牛魔王快出來看上帝」。這篇2017年發表的論文引入了Transformer神經網路架構,徹底改變了深度學習領域,並為今日生成式AI奠定基礎。

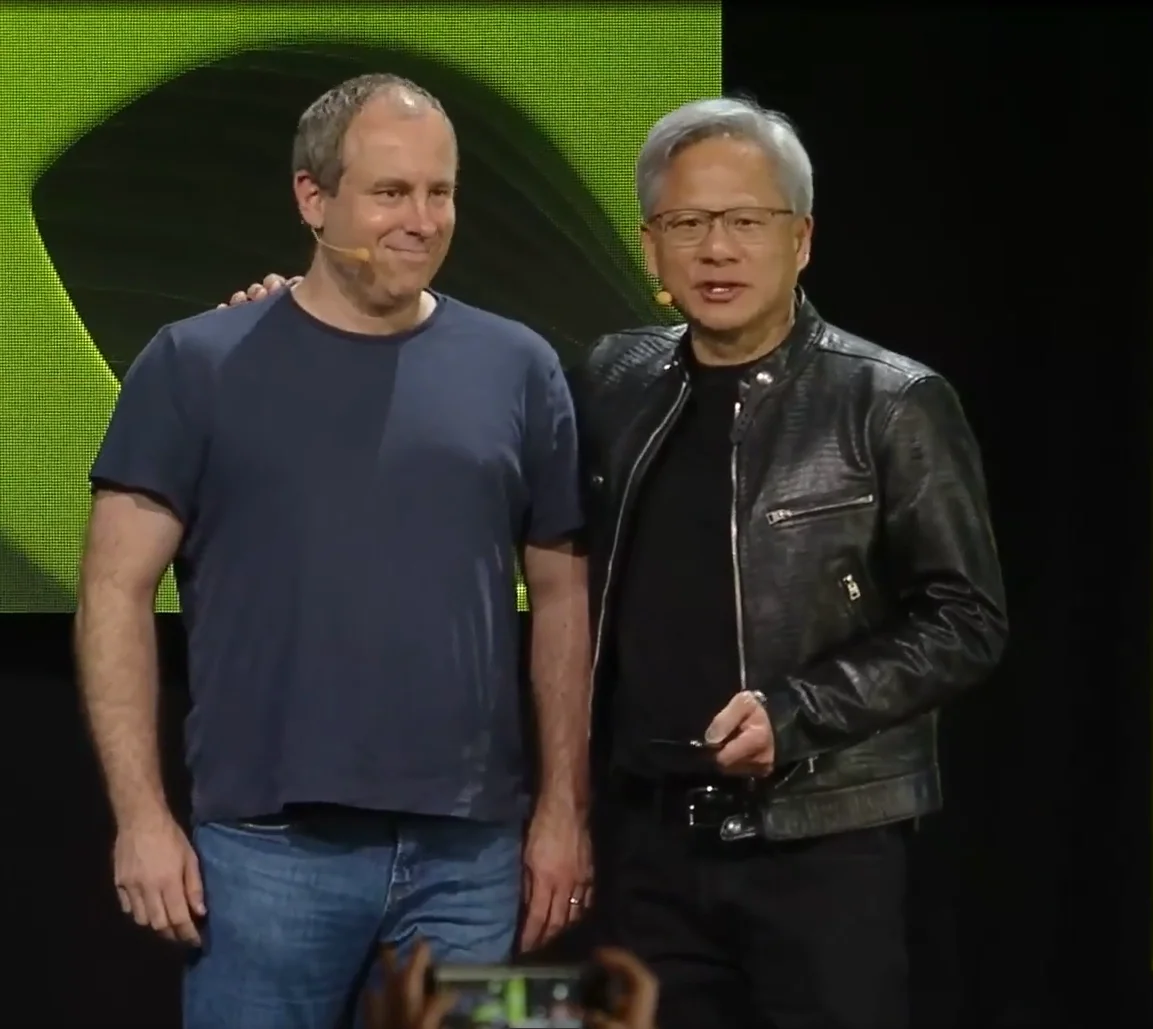

「今天我們所享受的一切都可以追溯到那個時刻,」黃仁勳對滿座的聽眾說道,「這是我們邀請『Attention Is All You Need』作者們共同回顧的原因。」

黃仁勳的電腦史觀:從60年代到AI革命

座談中,黃仁勳提供了一個引人入勝的電腦發展史脈絡。他指出,「電腦在過去60年基本上沒有太大變化。在我出生後的那一年——與我的出生沒有關係——現代電腦由IBM System 360定義」,引發全場笑聲。

他追溯了從1964年到PC革命,再到加速計算的發展歷程:「在PC革命的20年間,計算成本降低了10,000倍,這比歷史上任何有價值的商品降價速度都快。」他形象地比喻:「想像一下,如果生活中所有重要的東西都能降價10,000倍?一輛原本價值20,000美元的車現在只需要一美元。好吧,也許這就是Uber。」

這個幽默的歷史觀點為Transformer及生成式AI的重要性提供了背景:從序列運算到並行計算,再到如今的生成式AI革命。

令人莞爾的首度同聚

黃仁勳在開場時笑稱,儘管這七位Transformer發明者曾經共同完成了改變世界的論文,但「他們其實從未同時在同一個房間裡見過面。」這句話引發全場笑聲,也反映了現代遠端工作的特色。黃仁勳打趣道:「這種遠端工作已經失控到這種程度,但顯然並不妨礙創新和發明。」

座談會氛圍輕鬆活潑,黃仁勳表示在後台等待時,這群深度學習專家們「有很多深度學習笑話,還有很多辯論」。他調侃道:「我們將拋出笑話和辯論的話題,看看會引向何處。」團隊成員間的化學反應明顯,時而互相打趣,時而專業辯論。

Transformer八仙首度齊聚:「牛魔王快出來看上帝」

這場被觀眾戲稱為「牛魔王快出來看上帝」的座談,展示了這七位曾在Google共事的研究者如何在業界各處發光發熱,多數成為自己AI公司的創辦人:

- Ashish Vaswani:Essential AI創辦人兼CEO,專注於讓AI模型通過觀察學習解決新任務

- Noam Shazeer:Character.AI創辦人兼CEO,以高度熱情聞名,座談中激情四溢,與冷靜的黃仁勳形成鮮明對比,最近又回到Google Deepmind

- Jakob Uszkoreit:生物軟體公司Inceptive創辦人兼CEO,將AI應用於生物醫學,他形容是「編程蛋白質」

- Llion Jones:Sakana AI創辦人兼CTO,公司名稱意為「魚」,靈感來自魚群的集體智慧

- Aidan Gomez:Cohere創辦人兼CEO,專注於為企業提供AI平台

- Łukasz Kaiser:OpenAI技術團隊成員,座談中唯一仍為工程師而非CEO者,被黃仁勳戲稱為「我的英雄」

- Illia Polosukhin:區塊鏈公司NEAR Protocol共同創辦人,致力於解決AI訓練數據的版權和創作者獎勵問題

- Niki Parmar:和Ashish共同創辦了Essential AI,後加入Anthropic

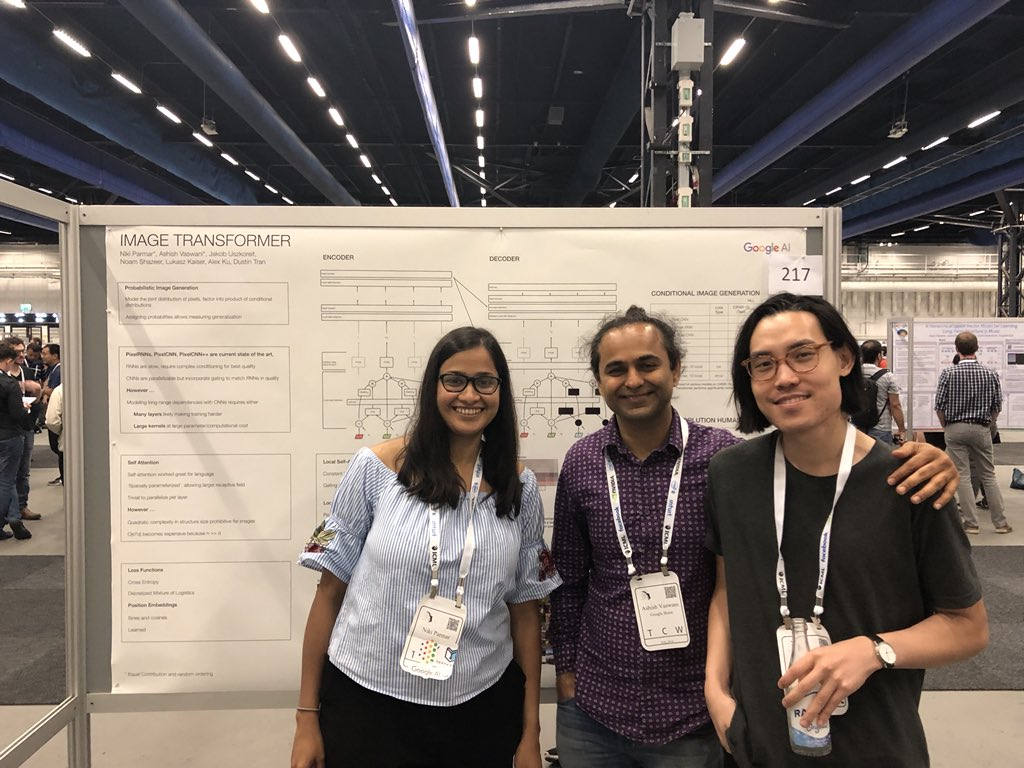

會中缺席的第八位作者,也是唯一的女性Niki Parmar,她因家庭緊急情況無法出席,使得這次聚會成為「八仙過海,七仙到場」的盛況。

名字背後的故事:非「變形金剛」靈感,卻致敬披頭四

座談中,作者們分享了Transformer名稱的由來。與許多人猜測的不同,這個名稱與熱門電影「變形金剛」(Transformers)沒有直接關聯。Jakob Uszkoreit最初提出了這個名稱,因為它準確描述了模型的功能——能夠轉換(transform)任何形式的數據。

儘管有些作者如Noam認為這名稱太過簡單,因為「幾乎所有機器學習模型都在進行轉換」,最終團隊還是採用了這個直觀而有力的名稱。Ashish回憶道,Jakob曾提出一個更複雜的名字「Cargonet」(結合卷積、注意力、識別等層的縮寫),但幸好被團隊否決了。

「Attention Is All You Need」這個引人注目的標題則來自Llion Jones的靈感,巧妙地致敬了披頭四(The Beatles)的經典歌曲「All You Need Is Love」。他解釋道:「在論文定稿時,我們正在進行模型簡化測試,移除各種組件看看效果如何。讓我們驚訝的是,當我們移除所有卷積組件後,模型反而表現更好了。」這個發現強調了注意力機制的重要性,成為論文標題的來源。

解決當時的瓶頸

研究團隊最初是為了克服循環神經網路(RNN)的限制。RNN在處理語言數據時需要逐字讀取,速度慢且無法並行處理。

「Google當時生成訓練數據的速度遠超過我們訓練最先進架構的速度,」Jakob回憶道。Noam則生動地比喻:「RNN就像蒸汽機,而Transformer則像內燃機。我們可以用蒸汽機完成工業革命,但那會很痛苦。有了內燃機,效率提高了許多倍。」

Illia Polosukhin幽默地補充說:「現在我們只是在等待核融合了。」暗示AI領域可能還有更劃時代的技術等待發現。

至於為何Transformer能比RNN更有效,Jakob解釋了兩者在處理資料方式上的根本差異:「RNN需要一次讀取一個詞」,而Transformer可以「轉換它操作的整個訊號」,能夠同時處理所有輸入,實現並行計算,大幅提高效率。

Lukasz Kaiser則有不同的觀點:「我個人認為我們從未真正學會如何用梯度下降訓練循環模型。也許這根本就是不可能的。」他認為也許人類,作為某種意義上的循環系統,並不是通過反向傳播(backward propoganda, 2024年諾貝爾物理學獎得主Geoffery Hinton在1987年對神經網絡研究的重要設計)來學習的,「所以也許有一種方法,只是不是梯度下降,這就是為什麼它如此難以解決。」

變形金剛是GPU:模型與硬體的共舞

座談中有個極為精彩的觀點來自Noam Shazeer,他將當前的AI發展形容為「模型與硬體的共舞」:「所有深度學習其實都是—我們在建造一個符合GPU形狀的AI模型。而現在,我們正在建造一個符合超級電腦形狀的AI模型。」

黃仁勳聽到後立即反駁:「讓你們知道,我們其實是在打造符合模型形狀的超級電腦。」這段交流引發笑聲,也精準地捕捉了硬體與軟體開發如何相互推動的現實。

Ashish Vaswani補充說,Transformer成功的兩個關鍵因素是「讓梯度下降算法開心」和「讓物理學開心」。他解釋道,Transformer的設計不僅適合數學優化,還能充分利用矩陣乘法的物理加速特性,這正是GPU的強項。

「每次我們添加一堆規則,總有一天梯度下降會比你學得更好,」Ashish說,「這就是Transformer—將AI模型塑造成GPU的形狀。」這種軟硬件協同演化的視角,完美解釋了為何Transformer能在NVIDIA加速計算平台上取得如此成功。

從未同處一室的研究團隊

座談會最令人驚訝的插曲是黃仁勳透露,儘管這群研究者共同完成了改變世界的論文,但「他們其實從未在同一個房間裡見過面」。這句話引發全場笑聲,反映了現代研究和遠端工作的新常態。

Transformer論文發表於2017年,Ashish Vaswani、Noam Shazeer、Niki Parmar、Jakob Uszkoreit、Llion Jones、Aidan Gomez、Lukasz Kaiser和Illia Polosukhin等八位作者合作完成。黃仁勳打趣地評論:「這種遠端工作已經失控到這種程度了,但顯然這並不妨礙創新與發明。」

在GTC 2024的座談中有七位作者出席,缺席的是Niki Parmar,因家庭緊急情況未能參加。黃仁勳表示「我們的心與祝福與她同在」。

當天座談現場人潮洶湧,黃仁勳開場時幽默地描述了聽眾的行為:「外面排著長隊,大家有秩序地進入這個房間。但一旦進來後,就變成完全的混亂。」他催促觀眾:「來吧,快點,快點!我要開始了!」這番話既顯示了這場座談的高度熱門程度,也展現了他親切隨和的主持風格。

Transformer模型的超乎預期成功

Transformer模型的廣泛應用範圍大大超出了開發者最初的預期。Aidan Gomez回憶道,Transformer儲存庫中很早就包含了處理各種資料類型的組件:「當我們開發Tensor2Tensor模型時,我們關注的不僅僅是語言,還包括圖像、音頻、文本等多模態輸入輸出。」

Jakob Uszkoreit強調,最初他們專注於機器翻譯,但一旦模型架構確定,很快就意識到它可以「將任何東西轉換為任何東西」。Aidan描述道,團隊非常早就有一個「北極星目標」,即建立能處理所有數據類型的通用模型,「看到它現在實現,真的非常令人興奮和欣慰。」

黃仁勳指出Transformer模型用於處理圖像時令人驚訝的效果。他觀察到知識本質上就是各種轉換:「圖像到文本,文本到圖像,文本到文本」,而Transformer的核心能力正是處理這類「張量到張量」的轉換。

到目前為止,這些想法已經拓展至生物醫學領域,Jakob形容為「生物軟體」,類似於「開始於程式碼並編譯成能在GPU上運行的東西」的電腦軟體。生物軟體始於某些行為的規格說明,然後通過深度學習翻譯成RNA分子,最終實現這些行為。

創新是如何發生的?從瓶頸到突破

創新往往來自於解決實際問題。團隊回憶當時他們面臨的多個挑戰:

Lukasz Kaiser負責機器翻譯項目,當時翻譯模型的表現還相當原始:「五年前這看起來太難了,你必須收集數據,可能它會翻譯,可能翻譯還有點錯。現在,這些模型甚至不需要任何數據就能學會翻譯,語言之間的翻譯能力自然而然浮現出來。」

Jakob Uszkoreit則解釋Google面臨的實際限制:「如果你想在搜尋中實際部署能夠閱讀大量文件的模型,你需要能夠快速處理的東西。而當時的模型,循環神經網路,做不到這一點。」他們生成訓練數據的速度遠超過訓練先進架構的速度。

黃仁勳透過電腦發展史的角度解釋加速計算的重要性,指出在PC革命20年間,計算成本降低了一萬倍,「比歷史上任何有價值的商品降價速度都快」。但後來這個速率停滯了,需要新的計算範式,這也正是Transformer和GPU加速計算結合的契機。

意想不到的突破:「我們把它扔掉,結果變得更好了」

Transformer的誕生充滿了意外與發現。Llion Jones回憶,他們最初設計的模型比最終發表的版本複雜得多,包含許多卷積層。

「我們最近開始移除模型的一些部分,看看它會變得多糟糕,」Llion解釋,「但令我們驚訝的是,它反而變得更好了,包括移除所有卷積解決方案。」

這種「減法思維」正是Transformer成功的關鍵。研究團隊勇於質疑假設,最終發現核心注意力機制才是真正的突破點。Noam補充說:「我們實際上是從那個骨架開始,然後添加東西...後來又把它們移除了。」

這個故事提醒我們,科學進步有時來自簡化而非複雜化,移除而非添加。黃仁勳稱讚道:「我們有一個感激你們工作的整個行業。」

有趣的性格對比:冷靜與熱情的AI先驅

座談中展現了研究者們截然不同的個性。黃仁勳在介紹完Aidan Gomez後,不禁打趣道:「我真的很喜歡的是,這是Aidan超級興奮時的樣子,而這是Noam超級冷靜時的樣子。」

這個對比令人莞爾:Aidan Gomez在座談中保持沉穩、條理分明的表達風格,即使談論激動人心的技術進展時也是如此;而Noam Shazeer則充滿激情,對AI的未來充滿熱情洋溢的展望。他誇張地表示Character.AI的使用者增長「瘋狂」,激動地談論著讓AI普及到「十億人」的願景。

黃仁勳的調侃引發全場笑聲,也突顯了這個領域中不同個性如何共同推動革命性的進步。

各有千秋的AI創業路

座談中,研究者們分享了離開Google創業的不同動機,展現了各自的思考方式:

Noam Shazeer解釋他為何在2021年創立Character.AI:「要讓這些模型更聰明,你不能在實驗室的真空中做到。你需要將它們放在人們手中,讓世界與這些模型互動,獲得反饋。」他熱情澎湃地表示要「幫助世界上的每一個人」,讓黃仁勳打趣說這是「深度學習的禪境」。

Jakob Uszkoreit則分享了更個人的故事:「我的第一個孩子在疫情期間出生,這讓我對生命的脆弱有了新的認識。」幾週後AlphaFold 2的蛋白質結構預測結果出爐,其中一個關鍵改進就是使用了Transformer。隨後mRNA新冠疫苗的效果也出來了。「這些事件讓我意識到,利用AI改進生物學幾乎是一種道德義務,」因此他創立了Inceptive。

Aidan Gomez則表示創立Cohere是因為看到一種「認知失調」:「計算機開始會說話了,這應該改變一切,改變每一個產品、我們工作的方式...但它沒有改變,我想彌合這種差距。」

未來展望:更智慧、更高效的AI

當被問及下一步發展時,研究者們提出了幾個關鍵方向:

「世界需要比Transformer更好的東西,」Aidan Gomez坦言,「我認為在座的所有人都希望它被一個能帶我們達到新高度的技術所取代。」

Jakob則強調了自適應計算的重要性:「關鍵是為每個問題分配恰當的計算資源。你不會想在簡單問題上花太多資源,也不會想在困難問題上資源不足。」

Llion補充道,他的公司正在利用演化計算來優化模型融合方法,探索如何更有效地結合現有模型。

從模型到產業革命

黃仁勳形容生成式AI正引領一場新的工業革命:「在這場新工業革命中,我們正在創造以前從未存在過的東西。」他描述了AI工廠如何將原始數據轉化為高價值的AI模型,就像早期工業革命中將水轉化為電力一樣。

「未來十年你不會想錯過,」黃仁勳預測,「令人難以置信的新能力將被發明出來。」

座談結束時,黃仁勳向每位研究者贈送了NVIDIA DGX-1 AI超級電腦的簽名封面板,上面寫著「你們改變了世界」。

座談結束時,黃仁勳向每位研究者贈送了NVIDIA DGX-1 AI超級電腦的簽名封面板,上面寫著「你們改變了世界」。這個儀式象徵了Transformer從學術想法到產業革命的歷程。

Aidan Gomez在結束前表達了一個共同願望:「我認為世界需要比Transformer更好的東西,我想在座的所有人都希望它被更優秀的技術所取代,帶我們到達新的高峰。」

LLMs改變了世界以後:Transformer八仙的後續發展

2017年這篇名為《Attention Is All You Need》的論文,介紹了 Transformer 模型架構,這個看似簡單的技術創新最終徹底改變了人工智慧的發展軌跡。八位作者在當時可能未曾預料到,他們的發明將在短短數年內,催生出 GPT、BERT、LLaMA 等改變世界的大型語言模型,徹底改變人類與機器的互動方式。

然而,更加引人入勝的是,這八位開創性研究者在點燃 AI 革命的火花後,各自選擇了不同的道路,將他們的遠見和技術專長帶向更廣闊的領域。讓我們來看看這些改變世界的人物如今在做什麼?

創業浪潮:從研究到商業

Transformer 論文的發表引發了一場人才大遷移。八位作者中有七位選擇離開 Google,投身創業潮流,只有一位繼續在大型研究機構工作。這種現象反映了 AI 技術從純研究領域走向實際應用的大趨勢。

Ashish Vaswani 和 Niki Parmar:AI 生產力工具的先驅

身為論文第一作者的 Ashish Vaswani 與唯一女性作者 Niki Parmar 走上了相似的道路。2021年,兩人離開 Google 共同創辦了 Adept AI Labs,專注於開發能理解並操作各類軟體的 AI 代理。雖然 Adept 獲得了超過 4 億美元融資,但兩人在創業初期就選擇了離開。

2023年,Vaswani 和 Parmar 再度聯手創立 Essential AI,致力於開發生成式 AI 生產力工具,希望深化人機協作,讓 AI 幫助人類更快完成複雜任務。這家新創公司很快就獲得了包括 Google 和 NVIDIA 在內的投資者支持,籌集到約 6,500 萬美元資金。兩位創始人正將他們對 Transformer 架構的深刻理解,轉化為能夠實際增強人類工作效率的產品。

Noam Shazeer:從對話 AI 到重返Google

作為在 Google 工作了近 20 年的資深研究員,Noam Shazeer 於 2021 年決定離開,與同事 Daniel De Freitas 共同創辦對話式 AI 公司 Character.AI。這家公司專注於讓用戶與擬真的虛擬角色對話,迅速獲得了市場的關注。Shazeer 的工作使他入選 TIME 雜誌 2023 年度全球百大 AI 人物。

然而,Shazeer 的故事出現了戲劇性轉折:2024 年,Google 以約 27 億美元的技術授權交易邀請他重返公司。目前他受聘擔任 Google 下一代大型模型專案 Gemini 的技術領導之一,將其在 Character.AI 開發對話代理的豐富經驗帶回到 Google,繼續引領尖端 AI 研發。

Aidan Gomez:從最年輕作者到 AI 企業家

Transformer 論文發表時,Aidan Gomez 僅是一名 20 歲的大學實習生,是八位作者中最年輕的一位。2019 年,還在牛津大學攻讀博士學位的 Gomez 就創立了 Cohere,專注於將大型語言模型應用於企業服務。

Cohere 迅速成長,目前估值超過 20 億美元,提供多種多語言大型模型 API 和企業級生成式 AI 解決方案。Gomez 不僅打造了成功的商業模式,還成立了學術研究部門 Cohere For AI,培養開放的 AI 研究社群,延續他早期對開放協作的熱情。作為年輕的 AI 領導者,Gomez 入選 TIME 雜誌 2023 年「最具影響力 AI 人物 100 人」榜單。

Jakob Uszkoreit:從語言模型到生物科技

Jakob Uszkoreit 在 2021 年選擇了一條獨特的道路。與其他專注於改進語言模型的同行不同,他與史丹佛大學計算生物學家 Rhiju Das 共同創辦了生物科技新創 Inceptive。這家公司位於加州帕洛阿托,致力於結合高度可擴展的生物實驗與深度學習,設計新一代 RNA 分子,用於開發創新療法。

在 Uszkoreit 的帶領下,Inceptive 已利用神經網路成功設計並合成出具功能的信使 RNA 分子。他勇於跳出舒適圈,將深度學習從語言 AI 領域轉向生物科技,展現出將 Transformer 的核心理念應用於解決人類健康難題的遠見。

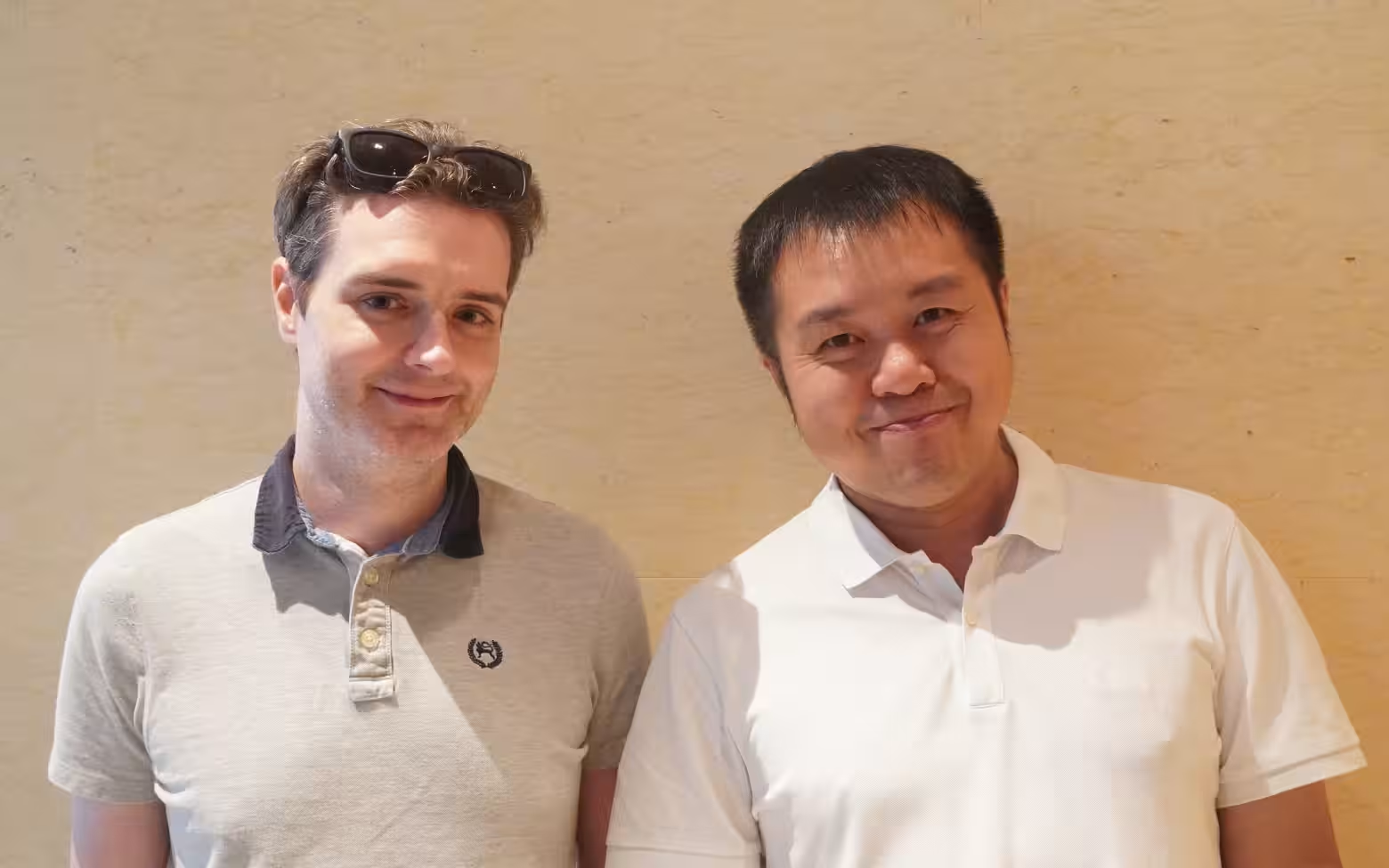

Llion Jones:多模型協作的新方向

來自威爾斯的 Llion Jones 擁有獨特的歐洲視角。在 Google Research 工作 12 年後,他於 2023 年與前同事 David Ha 在日本東京共同創辦 Sakana AI。公司名 Sakana(日語意為「魚」)靈感來自魚群協同游動的智慧,反映了 Jones 對「群體智能」在人工智慧中應用的興趣。

與當前主流「做大做強單一模型」的趨勢不同,Sakana AI 主打「多模型協作」架構,讓不同專精的小型模型合作解決複雜問題。這種創新思路可能為 AI 研發提供更節能、更靈活的新方向。Jones 選擇在日本發展,也展現了他對跨文化融合與汲取不同靈感的開放態度。

Illia Polosukhin:區塊鏈與 AI 的融合

烏克蘭出身的 Illia Polosukhin 選擇了一條與主流 AI 發展不同的道路。2017 年,他離開 Google 創立了 NEAR Protocol 區塊鏈平台,專注於提升區塊鏈的易用性與擴展性。平台於 2020 年正式上線,並吸引了眾多去中心化應用開發者。

2022 年起,Polosukhin 開始將 AI 引入區塊鏈領域,成立 NEAR.ai 實驗室,研發基於區塊鏈的機器學習基礎設施。他積極推動 AI 與區塊鏈技術的融合,探索解決 AI 訓練數據版權和創作者獎勵等問題,為生成式 AI 時代下的創作者權益保護提供新思路。

Łukasz Kaiser:唯一的研究堅守者

波蘭出身的理論計算機科學家 Łukasz Kaiser 是八位作者中唯一沒有創辦公司的人。2021 年 6 月,他從 Google 離職加盟 OpenAI,參與了 ChatGPT 和多模態大型模型 GPT-4 的研發工作。

Kaiser 被視為 OpenAI 的核心技術「魔法師」之一,據報導,他是 OpenAI 一項名為 Q* 的新技術共同發明人——OpenAI CEO Sam Altman 曾暗示這將「揭開無知的面紗,推動發現的前沿」。這位低調的研究者選擇繼續探索 AI 的學術前沿,而非投身商業浪潮,展現了對純粹技術突破的執著。

不同道路,共同願景

Transformer 論文的八位作者來自不同國家和文化背景,他們的後續發展路徑也各不相同:有人專注企業應用,有人探索生物科技,有人深入區塊鏈領域,有人繼續鑽研基礎研究。然而,他們都在各自的領域將 Transformer 的理念推向更遠,用不同方式實現 AI 技術造福人類的願景。

Transformer 論文《Attention Is All You Need》八位作者資訊表

| 作者姓名 | 出身背景 | 學歷 | 職業經歷 | 近期動向 |

|---|---|---|---|---|

| Ashish Vaswani | 印度出身,童年於中東度過,後移居美國加州 | • 印度 BIT Mesra 計算機科學與工程學士 • 2014年 美國南加州大學(USC)博士學位,專攻機器翻譯 |

Google Brain 團隊研究員 | • 2021年與 Niki Parmar 共同創辦 Adept AI Labs • 2023年創立 Essential AI,專注生成式 AI 工具開發 |

| Noam Shazeer | 美國賓夕法尼亞州費城,猶太背景,父親為數學教師兼工程師 | • 杜克大學數學和計算機科學學士(1994-1998) • 就讀加州大學柏克萊分校研究所(未完成學位) |

• Google 研究員近20年(2000-2021) • Transformer 模型和語言模型研究的重要貢獻者 |

• 2021年共同創辦 Character.AI • 2024年重返 Google 領導 Gemini 專案 |

| Jakob Uszkoreit | 德國出身,父親 Hans Uszkoreit 為知名計算語言學教授 | • 柏林工業大學計算機科學與數學碩士 • 攻讀博士期間轉入業界,中止博士學程 |

• Google Brain 團隊研究員(2008-2021) • 領導開發 Google Assistant 語義解析系統和早期翻譯系統 |

2021年創辦生物科技新創 Inceptive,結合深度學習與生物實驗 |

| Llion Jones | 英國威爾斯小村莊,母語為威爾斯語 | 英國伯明罕大學電腦科學學士與碩士(2004-2009) | Google Research 研究員(2011-2023) | 2023年在日本東京共同創辦 Sakana AI,專注多模型協作 |

| Aidan Gomez | 英加雙重國籍,加拿大安大略省 Brighton 小鎮長大 | • 多倫多大學計算機科學與數學學士 • 牛津大學計算機科學博士(2024年完成) |

• Google Brain 實習生(2017年,僅20歲) • Transformer 論文最年輕共同作者 |

2019年創立 Cohere,專注企業級語言模型應用 |

| Łukasz Kaiser | 波蘭出身,理論計算機科學家 | • 德國亞琛工業大學(RWTH Aachen)數學博士 • 法國國家資訊與自動化研究所(INRIA)博士後 |

• Google Brain 研究科學家(2013-2021) • TensorFlow 核心開發者之一 |

2021年加入 OpenAI,參與 ChatGPT 和 GPT-4 研發 |

| Illia Polosukhin | 烏克蘭出身,自幼在當地長大 | 烏克蘭哈爾科夫國立大學應用數學與計算機科學碩士 | • Google Research 研究員(2014-2017) • TensorFlow 框架開發參與者 |

2017年創立 NEAR Protocol 區塊鏈平台,探索 AI 與區塊鏈融合 |

| Niki Parmar | 印度裔,Transformer 論文唯一女性作者 | • 印度浦那資訊科技學院(PICT)工學學士 • 美國南加州大學電腦科學碩士(2015年) |

• Google 軟體工程師(2015年入職) • 2017年加入 Google Brain 團隊 |

2023年與 Vaswani 創立 Essential AI,開發生產力 AI 工具 |

正如 Transformer 模型本身的設計理念——通過並行處理和注意力機制高效處理複雜信息——這八位創新者也以各自獨特但又彼此呼應的方式,繼續開拓人工智慧的疆界。他們共同證明,真正改變世界的不只是技術本身,還有敢於打破常規、持續創新的精神。

從 2017 年那篇開創性論文誕生至今,短短數年間人工智慧已經發生了翻天覆地的變化。而這場變革的種子播種者們,現在正各自在不同的土壤上培育著 AI 未來的各種可能性。